Les Big Data sont générées à partir de 3 activités numériques principales :

- Les individus laissent des empreintes numériques lorsqu'ils naviguent sur le Web, achètent des articles en ligne, utilisent le courrier électronique ou interagissent avec les médias sociaux.

- Les entreprises, en plus de générer des empreintes de données similaires, sont également désireuses de recueillir et d'analyser autant de données que possible pour leur propre usage commercial.

- Enfin, les machines échangent continuellement des données entre elles sans aucune intervention humaine.

Chaque industrie génère des données importantes : des ensembles de données extrêmement vastes et diversifiés qui, une fois analysés dans leur ensemble, peuvent révéler des modèles, des tendances et des associations, surtout en ce qui concerne le comportement et les interactions humaines.

Le Big Data ne peut être utile aux consommateurs et aux entreprises que s'il est fiable, robuste et sécurisé.

La clé du succès réside dans la façon dont les Big data sont gérées.

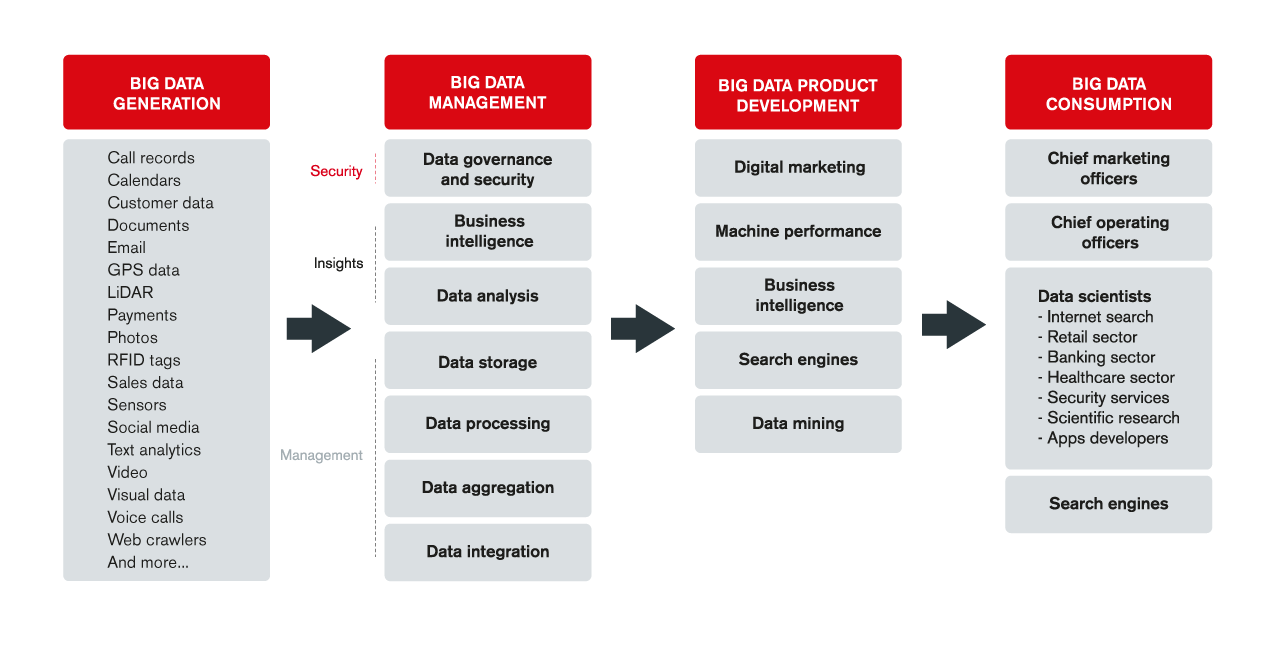

Le graphique de la chaîne de valeur ci-dessous illustre les quatre principaux segments de la grande chaîne de valeur des données :

- La production de Big Data

- La gestion du Big Data

- Le développement de technologies autour du Big Data

- La consommation de Big data

Production de Big Data

Les Big Data sont produites par des activités numériques de toutes sortes : enregistrements d'appels, courriels, activités des capteurs, paiements, messages sur les médias sociaux, photos, vidéos, et bien plus encore.

Elles sont également produites par des machines, tant matérielles que logicielles, sous forme d'échanges de données M2M, particulièrement importants à l'ère de l'IoT, où les dispositifs communiquent entre eux sans aucune forme d'intervention humaine.

Bon nombre de technologies en pointe aujourd'hui sont inextricablement liés à cette explosion du Big Data.

Celles-ci comprennent l'IA, la réalité virtuelle (RV), l'AR, la télévision sur Internet et l'IOT (qui couvre un éventail de domaines, notamment la voiture connectée, la maison automatisée, le vêtement connecté, l'Internet industriel, et les villes intelligentes).

Gestion de Big Data

La majorité des données générées ne sont pas structurées et doivent être gérées correctement.

Les Big Data sont généralement gérées dans des centres de données, dans le cloud public, privé ou on-premise.

Dans l'ensemble, l'objectif de la gestion du Big Data est de sécuriser les données (grâce à l'utilisation de la gouvernance des données et des technologies de sécurité), de recueillir des informations à partir des données (à l'aide d'outils d'analyse de données et de BI) et de gérer les données (en utilisant de technologies de stockage, de traitement, d'agrégation et d'intégration).

Étant donné que les Big Data ne peuvent être utiles aux consommateurs et aux entreprises que si elles sont fiables, robustes et sûres, leur management est d'une importance vitale.

- Data Governance & Security (Gouvernance et sécurité des données) :

- Data Security : La sécurité des données est d'une importance capitale pour les entreprises de tous types.

- Data Quality Management : La gouvernance et la sécurité des données couvrent la qualité, la disponibilité, l'ergonomie et l'intégrité des données.

- Master Data Management : Le MDM désigne l'effort déployé par une entreprise pour créer un point de référence unique pour toutes ses données critiques, et vise à surmonter les défis tels que la mauvaise gouvernance des données, l'incohérence, et la manipulation des données.

- Business Intelligence :

La BI est un ensemble de technologies, de processus, d'architectures et de méthodologies qui convertissent les données brutes en données exploitables capables d' orienter les décisions.

Les techniques impliquées dans la BI incluent la visualisation des données et la découverte des données.

La visualisation des données utilise la représentation visuelle pour améliorer la compréhension des données complexes et non structurées, tandis que la découverte de données permet aux utilisateurs de discerner des schémas d'action grâce à l'application d'analyses avancées.

- Data Visualization

- Reporting

- Data Discovery

- Data Analytics (Analyse des données) :

L'analyse des données correspond à l'évaluation des données à l'aide de techniques statistiques et analytiques. L'objectif est d'obtenir des informations utiles pour la prise de décisions.

Certains des outils utilisés dans l'analyse des données comprennent :

- Predictive Analysis : L'analyse prédictive utilise les données actuelles et historiques pour prévoir les tendances futures

- Data Mining : L'exploration de données est une combinaison de prétraitement, d'extraction, et l'évaluation des données

- AI framework : Les IA frameworks utilisent des techniques d'apprentissage machine (Machine Learning) pour tirer des conclusions à partir de données sans intervention humaine.

- Data Storage (Stockage des données) :

L'un des éléments clés de la gestion des Big Data est la collecte et la gestion de grands ensembles de données pour permettre des analyses en temps réel.

L'objectif du stockage des données dans le cloud ou sur site est de structurer les données de manière à ce qu'elles puissent être facilement récupérées et analysées.

Les données sont généralement stockées sous diverses formes, notamment :

- Distributed File Systems : Les systèmes de fichiers distribués stockent les fichiers dans un ou plusieurs serveurs tout en fournissant un accès contrôlé aux utilisateurs

- Relational Databases : Les bases de données relationnelles stockent les données sous forme de tableaux décrivant la relation entre les ensembles de données

- Non-relational Databases : Les bases de données non relationnelles stockent des fichiers sans montrer le lien entre les ensembles de données.

- Data Processing (Traitement des données) :

Le traitement des données est l'étape durant laquelle les données brutes sont transformées en informations utiles, par traitement par lots ou par flux (le traitement par lots traite des données non continues, tandis que le traitement par flux traite des données continues).

Il implique de plus en plus l'utilisation d'algorithmes d'apprentissage machine qui peuvent automatiser l'ensemble du processus pour obtenir l'information souhaitée sous forme de graphiques, de tableaux, de tableaux, d'images, etc.

L'exécution en langage de requête séquentielle (SQL) est également une méthode largement utilisée dans le traitement des données, en particulier pour récupérer ou modifier des données existantes.

- Stream ou Batch Processing : Traitement par flux ou par lots

- Machine Learning : Apprentissage machine

- SQL Exécution : Exécution SQL

- Data Aggregation (Aggrégation des données) :

L'agrégation des données consiste à synthétiser les données dans un format présentable qui peut faciliter l'analyse statistique.

Les composantes de l'agrégation des données sont l'entreposage (data warehouse) et la réplication des données.

Le Data warehouse implique la construction d'un dépôt de données en recherchant et en recueillant des données à partir de sources disparates. L'objectif est d'appuyer une prise de décision fondée sur l'analyse.

La réplication de données consiste à stocker les données dans plusieurs endroits pour améliorer l'accessibilité.

Les entreprises utilisent ces solutions pour éliminer la duplication des données et révéler des tendances cachées et des modèles.

- Data warehousing: Entrepôt de Données

- Data Replication : Réplication de Données

- Data Integration (Intégration des données) :

L'intégration des données comprend trois fonctions :

- ETL (Extract, Transform, Load) : L'ETL est utilisée pour copier des données provenant de sources multiples et les placer dans un système de destination, de sorte que les données proviennent d'une seule source (extrait), converties en un formulaire qui peut être analysé (transformé) et transférées dans un entrepôt de données ou un autre système (charge).

- Data Preparation : La préparation des données comprend la transformation de données brutes non structurées en données structurées plus faciles à utiliser./li>

- Data Exchange : L'échange de données fait référence au processus par lequel les données sont structurées de telle sorte qu'elles correspondent au format requis et peuvent être échangées entre différents utilisateurs finaux.

Data Modernisation, Big Data

Les équipes de Claranet vous accompagnent dans la réussite de vos projets Data et Big Data